DIFF Transformer: Mô hình mới nâng cao hiệu suất mô hình ngôn ngữ lớn

Nhóm nghiên cứu từ Microsoft AI và Trường ĐH Thanh Hoa đã giới thiệu một kiến trúc mới được gọi là DIFF Transformer (Transformer khác biệt) nhằm tăng cường hiệu suất của mô hình ngôn ngữ lớn. Kiến trúc này cải thiện cách mô hình xử lý ngữ cảnh và giảm thiểu sự can thiệp của thông tin không liên quan, từ đó tăng cường cơ chế chú ý.

Đặc điểm chính của DIFF Transformer là cơ chế chú ý khác biệt. Nó tính toán chú ý bằng cách so sánh hai bản đồ chú ý độc lập, giúp mô hình tập trung vào các phần liên quan của đầu vào một cách hiệu quả hơn. Sự thay đổi này cải thiện độ chính xác của mô hình, đặc biệt trong các tác vụ như trả lời câu hỏi và tóm tắt văn bản.

Kiến trúc này cũng tăng cường khả năng mở rộng, cho phép đạt được hiệu suất tương tự như các mô hình lớn hơn với ít tài nguyên huấn luyện hơn. Sự hiệu quả này giúp xử lý chuỗi dữ liệu dài, phù hợp cho các tác vụ đòi hỏi xử lý lượng lớn thông tin cùng lúc.

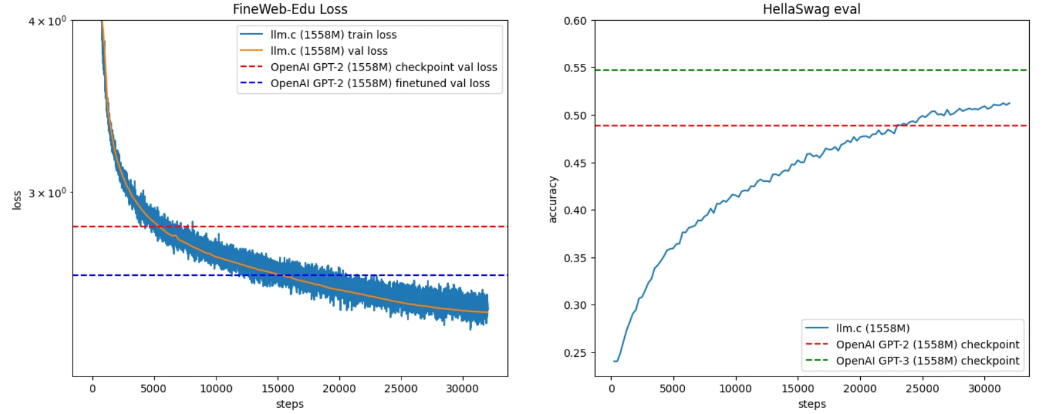

Theo các thí nghiệm, DIFF Transformer vượt trội hơn các mô hình Transformer truyền thống trong các tác vụ như mô hình hóa ngôn ngữ và truy xuất thông tin. Nó cung cấp hiệu suất và hiệu quả cao hơn trong các mô hình ngôn ngữ lớn, đồng thời cải thiện việc mô hình hóa ngữ cảnh dài, truy xuất thông tin quan trọng, giảm thiểu hiện tượng ảo tưởng và học ngữ cảnh. Những cải tiến này tăng cường độ chính xác trên các bộ dữ liệu khác nhau và tăng cường khả năng kháng perturbation đối với thứ tự của dữ liệu đầu vào, làm cho DIFF Transformer thích hợp hơn cho môi trường có tài nguyên hạn chế.

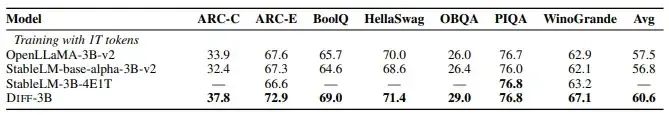

Bảng dưới đây so sánh hiệu suất không mẫu mực của DIFF Transformer với một số mô hình Transformer đã được đào tạo tốt, bao gồm OpenLLaMA-v2-3B, StableLM-base-alpha-3B-v2 và StableLM-3B-4E1T. DIFF Transformer thể hiện kết quả tốt hơn hoặc tương đương.

Cộng đồng người yêu thích và chuyên gia tỏ ra quan tâm đến ứng dụng thực tế của DIFF Transformer, đặc biệt là trong các tình huống cần nhiều tài nguyên tính toán để đạt được độ chính xác dự đoán cao hơn.

Nhà khoa học dữ liệu Kuldeep Singh chia sẻ trên X:

Nhà nghiên cứu AI Manu Otel viết:

Bài viết này nhấn mạnh sự đánh đổi giữa chi phí tính toán và độ chính xác dự đoán. Mặc dù DIFF Transformer đòi hỏi thực hiện hai hoạt động chú ý, điều này có thể làm chậm quá trình huấn luyện và suy luận, nhưng có người đoán rằng điều này có thể dẫn đến kết quả tốt hơn với ít vòng lặp huấn luyện hoặc ít dữ liệu hơn.