Giáo sư Qiu Xipeng từ Đại học Phục Đán chia sẻ tiến triển trong việc phát triển MOSS 2: Làm thế nào để hiện thực hóa mô hình thế giới?

Năm ngoái, sau sự bùng nổ của ChatGPT, Trung Quốc đã chứng kiến cuộc chiến giữa hàng trăm mô hình trí tuệ nhân tạo. Trong số đó, Phòng thí nghiệm Xử lý Ngôn ngữ Tự nhiên thuộc Đại học Fudan đã công bố mô hình đối thoại đầu tiên ở Trung Quốc giống như ChatGPT, được gọi là MOSS, vào tháng 2 năm ngoái. Tuy nhiên, chỉ trong vòng 24 giờ sau khi ra mắt, do áp lực truy cập đột ngột quá lớn, máy chủ của MOSS đã báo cáo quá tải lưu lượng và không thể truy cập.

Phòng thí nghiệm đã giải thích rằng MOSS vẫn còn rất non trẻ, nguồn tài nguyên tính toán không đủ để hỗ trợ lượng truy cập khổng lồ này. Mô hình này còn cách xa ChatGPT rất nhiều. Việc công bố MOSS đã đánh dấu một cột mốc quan trọng, chứng minh rằng việc phát triển mô hình ngôn ngữ lớn có thể thực hiện được ngay cả với nguồn tài nguyên hạn chế. Đồng thời, nó cũng cung cấp một tham chiếu quan trọng về mặt kỹ thuật và kinh nghiệm cho các nhà nghiên cứu và nhà phát triển trên toàn thế giới, đồng thời nâng cao niềm tin của người dân Trung Quốc về khả năng phát triển mô hình ngôn ngữ lớn.

Đến nay, đã hơn một năm kể từ ngày MOSS ra mắt, tại Diễn đàn Mô hình lớn CCF được tổ chức vào ngày 6 tháng 6, Giáo sư Qiu Xipeng thuộc Khoa Máy tính Đại học Fudan đã thành thật chia sẻ rằng khung công nghệ mà MOSS sử dụng khi ra mắt là của thời kỳ GPT-2, so với các mô hình sau này như LLaMA, khung công nghệ này đã trở nên lỗi thời. Hơn nữa, lượng dữ liệu huấn luyện và số lượng tham số cũng không đủ, dẫn đến khả năng hạn chế của mô hình.

Giáo sư Qiu Xipeng cho biết, con đường phát triển của MOSS trước đây tương tự như OpenAI, nhưng do dữ liệu học tập của học thuật giới còn hạn chế, nhóm đã sử dụng nhiều hơn phương pháp “Phản hồi của AI” thay vì phương pháp chưng cất phổ biến sau này. Nhóm đã xây dựng nhiều lệnh tự động, thông qua việc sử dụng lượng dữ liệu lớn được tạo ra bằng cách sử dụng AI để huấn luyện mô hình và điều chỉnh nhu cầu của con người.

Tại diễn đàn này, Giáo sư Qiu Xipeng đã giới thiệu chi tiết về những tiến bộ mới nhất trong việc phát triển MOSS. Bài viết này dựa trên nội dung bài giảng của Giáo sư Qiu, được chỉnh sửa để giữ nguyên ý nghĩa ban đầu, nhằm mang lại cho độc giả cái nhìn sâu sắc về những phát triển mới nhất.

AlphaGo đã đạt được những bước tiến đáng kể, nhưng nó vẫn thuộc về thế hệ trí tuệ nhân tạo cũ (trí tuệ nhân tạo yếu), tức là một mô hình giải quyết một nhiệm vụ cụ thể. Ngày nay, với đại diện là ChatGPT, trí tuệ nhân tạo đa nhiệm, sử dụng một mô hình để giải quyết nhiều nhiệm vụ khác nhau, tức là khả năng đa nhiệm, là hướng đi dẫn đến trí tuệ nhân tạo tổng hợp (AGI).

Giáo sư Qiu Xipeng cho biết, trong thập kỷ qua, lĩnh vực xử lý ngôn ngữ tự nhiên đã trải qua sự chuyển đổi từ từ. Trước đây, có rất nhiều nhiệm vụ khác nhau trong xử lý ngôn ngữ tự nhiên, như phân loại, khớp, ghi chú chuỗi, hiểu đọc, phân tích câu, v.v. Những nhiệm vụ này dần dần hội tụ lại thành nhiệm vụ mô hình ngôn ngữ, và mô hình ngôn ngữ dần thống nhất tất cả các nhiệm vụ xử lý ngôn ngữ tự nhiên.

Tại sao chúng ta lại bắt đầu từ mô hình chung như ChatGPT hoặc mô hình ngôn ngữ lớn? Theo Qiu Xipeng, điểm then chốt là hiện nay ngôn ngữ, theo một cách nào đó, là cách con người nhận thức về thế giới, phản ánh trong não của họ. Ngôn ngữ ở đây không phải là ngữ pháp thuần túy, mà là thông qua ngôn ngữ, con người truyền đạt tri thức của mình.

Tri thức được tổng kết bởi con người cần được tổng hợp bằng ngôn ngữ, và ngôn ngữ đại diện cho sự nén tri thức của trí tuệ con người đối với thế giới. Hiện nay, trong lĩnh vực trí tuệ nhân tạo có câu nói “Nén tức là thông minh”, tỷ lệ nén càng cao thì mức độ thông minh càng cao. Đôi khi, ngôn ngữ chính là sự nén cực đại của thế giới, mặc dù điều này được hoàn thành bởi trí tuệ con người.

Xây dựng tri thức về thế giới không cần thông qua ngôn ngữ, mà có thể cho phép mô hình quan sát thế giới và tự khám phá ra quy luật của thế giới, nhưng điều này thường rất khó khăn.

Hiện nay, mô hình ngôn ngữ lớn có tri thức về thế giới, bước đầu tiên được hoàn thành bởi con người. Con người quan sát thế giới, tổng hợp tri thức, và viết nó dưới dạng văn bản. Mô hình lớn học hỏi thông qua cách học tập mô phỏng, và đưa tri thức vào mô hình, đồng thời giao tiếp với thế giới thông qua ngôn ngữ. Cần lưu ý rằng, khi giao tiếp với thế giới, không nhất thiết phải giới hạn ở ngôn ngữ tự nhiên.

“Chúng tôi cuối cùng muốn đạt được cái gọi là ‘mô hình thế giới’, tức là cho phép mô hình tự thân giao tiếp với thế giới, quan sát và hiểu thế giới, và đưa ra quyết định tương ứng.” Giáo sư Qiu Xipeng nói. Đây cũng là mục tiêu mà nhóm đã đặt ra cho thế hệ thứ hai của MOSS sau khi ra mắt thế hệ đầu tiên của MOSS.

Khái niệm về mô hình thế giới được đề xuất từ rất sớm, nó có thể tránh được những nhược điểm của mô hình ngôn ngữ, nhưng con đường thực hiện nó không rõ ràng. Nhóm của Qiu Xipeng cho rằng, ngay cả mô hình thế giới cũng cần dựa vào mô hình ngôn ngữ lớn làm nền tảng. Do đó, một trong những hướng nỗ lực của phòng thí nghiệm là làm thế nào để biến mô hình ngôn ngữ lớn hiện tại thành mô hình thế giới lý tưởng.

Ý tưởng này cũng có sự hỗ trợ từ thực tế. Nhiều nhà nghiên cứu đã thực hiện các thí nghiệm với GPT-4 và phát hiện ra rằng GPT-4 đã có khái niệm thời gian và không gian rất mạnh mẽ, và có kiến thức về các vật thể trong thế giới thực, chỉ cần cần được ánh xạ vào không gian biểu tượng để có sự phù hợp tốt hơn.

Giáo sư Qiu Xipeng cũng đề cập rằng, đây cũng là khái niệm nóng hiện nay: Trí tuệ có cơ thể + Mô hình thế giới.

“Chúng tôi muốn trao cho mô hình ngôn ngữ lớn khả năng cảm nhận, tăng cường khả năng lập kế hoạch và ra quyết định, cũng như cải thiện khả năng nhớ và sử dụng công cụ, v.v., cần thông qua việc liên tục tương tác với thế giới thực để học hỏi. MOSS thế hệ 2 hy vọng sẽ tập trung vào lĩnh vực này.” Giáo sư Qiu Xipeng nhấn mạnh.

“Nếu một mô hình thường xuyên tương tác với thế giới, mô hình hiện tại chắc chắn không thể đáp ứng yêu cầu.” Giáo sư Qiu Xipeng ví dụ, làm thế nào để dữ liệu tương tác và mô hình có thể được cải thiện, cách sử dụng công cụ, đa phương thức và trí tuệ nhân tạo một cách hiệu quả đều cần được giải quyết.

Trong việc xây dựng cấu trúc hiệu quả, nhóm đã thực hiện nhiều cải tiến trên KV-Cache, giúp thế hệ thứ hai của mô hình có tính phân tán tốt hơn, giảm đáng kể chi phí, ví dụ, tốc độ tính toán cho tài liệu dài có thể tăng khoảng 70%, đồng thời duy trì khả năng không bị suy giảm nhiều.

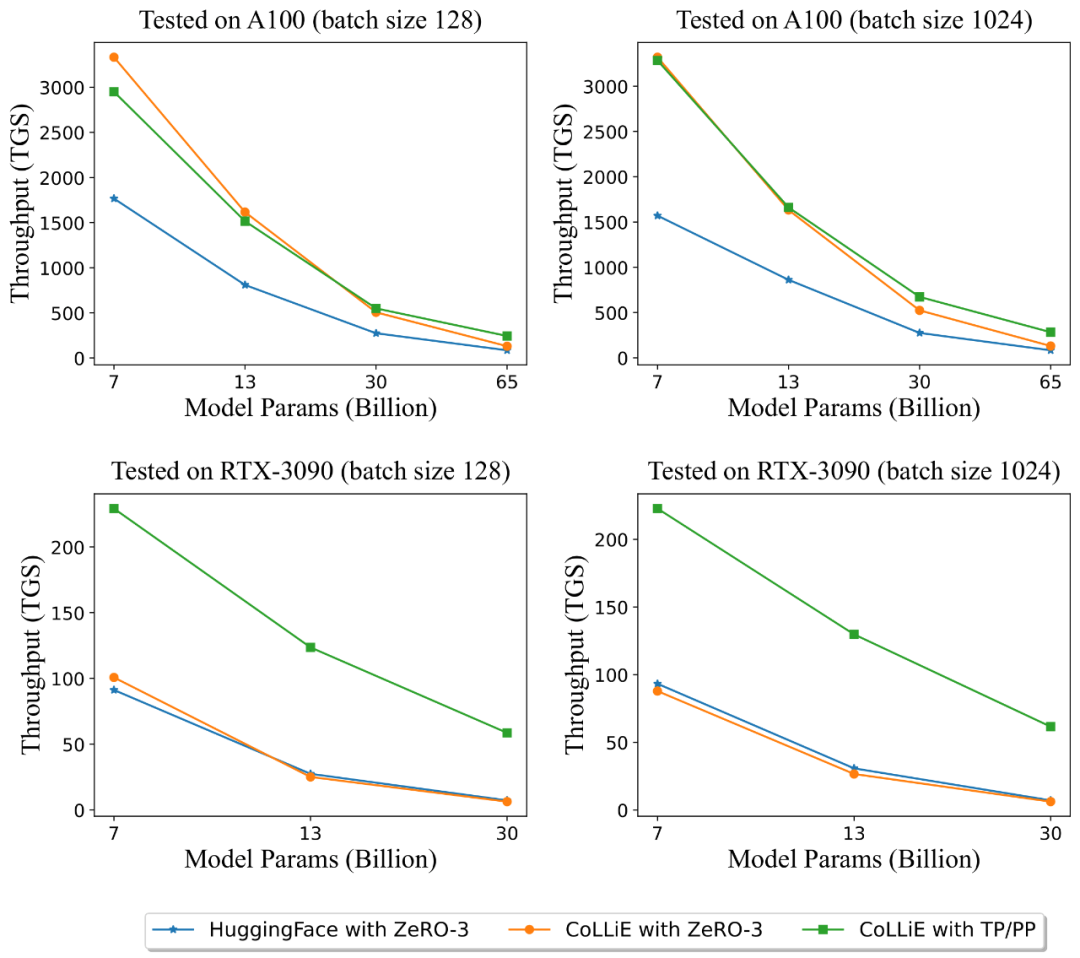

Về việc cải tiến cấu trúc cơ bản, nhóm đã viết lại Attention Kernel bằng Triton, giúp mô hình tận dụng tối đa phần cứng để tăng cường khả năng của mình. Nhóm cũng đã phát hành một công cụ có tên CoLLiE (Shepherd Dog): Một công cụ hiệu quả để điều chỉnh mô hình lớn như LLaMA (Alpaca).

CoLLiE tích hợp các chiến lược song song hiện có, phương pháp điều chỉnh tham số hiệu quả và tối ưu hóa hiệu quả, giúp tăng tốc độ huấn luyện, cải thiện chất lượng huấn luyện và giảm chi phí huấn luyện. Ngoài MOSS, CoLLiE cũng hỗ trợ các mô hình như InternLM, LLaMA, ChatGLM.

Kết quả thông lượng khi sử dụng Adam tối ưu trên A100 và RTX-3090 ở các kích thước lô khác nhau

Trong MOSS thế hệ 2, nhóm đã phát triển nhiều khả năng tiếng Trung. Giáo sư Qiu Xipeng nhấn mạnh, “khả năng tiếng Trung này không giống như xếp hạng trên bảng xếp hạng. Bảng xếp hạng hiện tại và nhu cầu thực tế của người dùng có sự khác biệt khá lớn, do đó chúng tôi đã xây dựng hàng nghìn điểm khả năng, sắp xếp và tăng cường theo các hệ thống khả năng khác nhau, mang lại trải nghiệm sử dụng rất tốt cho người dùng.” Những dữ liệu này có thể được công bố trong tương lai như tập huấn luyện và đánh giá.

“Khả năng đa phương thức đóng vai trò quan trọng đối với cấu trúc thế hệ tiếp theo.” Giáo sư Qiu Xipeng nhấn mạnh. Tuy nhiên, hiện tại, đa phương thức chỉ là đa phương thức vào, đầu ra là văn bản đa phương thức. Điều này không đáp ứng yêu cầu của khả năng đa phương thức có cơ thể.

Vậy làm thế nào để hòa nhập giữa các phương thức? Nhóm đã đề xuất ý tưởng “dựa vào mô hình ngôn ngữ, có khả năng đầu vào và đầu ra đa phương thức”.

Việc thực hiện cấu trúc như vậy không hề dễ dàng, đặc biệt là việc kết hợp giữa các phương thức một cách linh hoạt. Nhóm đã bắt đầu công việc này vào tháng 5 năm ngoái, và đã công bố SpeechGPT. Khi đó, nhóm đã nghĩ đến phương pháp rời rạc hóa. Việc rời rạc hóa tín hiệu liên tục như âm thanh, hình ảnh, âm thanh có lợi ích là có thể trộn lẫn với văn bản một cách ngẫu nhiên, cũng như hỗ trợ việc xuất bản hình ảnh.

Ví dụ về âm thanh, âm thanh là một tín hiệu liên tục, thông qua Tokenizer, thông tin âm thanh được rời rạc hóa. Nhân viên phát triển có thể coi âm thanh như một ngôn ngữ mới, nó có từ điển riêng, chỉ cần thêm từ điển này vào là có thể huấn luyện. Phương pháp này là cách huấn luyện mô hình bằng cách coi âm thanh như một ngôn ngữ mới.

Trong âm thanh, ngoài thông tin âm thanh Speech, còn có rất nhiều thông tin cảm xúc phong phú cần được giữ lại. Nhóm đã đề xuất công cụ rời rạc hóa âm thanh Speech Tokenizer, sử dụng lượng thông tin âm thanh lớn để huấn luyện, thực hiện việc tách tự động thông tin ngôn ngữ và không ngôn ngữ, có thể chỉ trích xuất thông tin ngôn ngữ, hoặc thông tin không ngôn ngữ hoặc thông tin ngôn ngữ phong phú. Điều này cho phép mô hình ngôn ngữ lớn trực tiếp giao tiếp với âm thanh mà không cần thông qua TTS hay ASR. Mô hình lớn như vậy có khả năng giao tiếp đa phương thức, lệnh và phản hồi có thể đa phương thức, rất linh hoạt.

“Gần đây, GPT-4o đã thể hiện triển vọng của con đường này. Chúng tôi chưa đạt được mức độ đó, nhưng GPT-4o đã thể hiện khả năng giao tiếp rất tốt. Nó là âm thanh vào, âm thanh ra, tương tự như SpeechGPT. Cách tiếp cận end-to-end này sẽ cho phép mô hình ngôn ngữ lớn có khả năng giao tiếp mạnh mẽ.” Giáo sư Qiu Xipeng nói.

Giáo sư Qiu Xipeng cho biết, ý tưởng này được mở rộng sang đa phương thức, tất cả các tín hiệu liên tục có thể được token hóa, tạo ra bất kỳ sự kết hợp token nào. Tất cả các phương thức sau khi được token hóa có thể được tạo ra theo dạng tự hồi quy, các từ được tạo ra thông qua bộ khôi phục được khôi phục lại thành các phương thức gốc. Đây là sự mở rộng đa phương thức.

Giáo sư Qiu Xipeng tiết lộ, giai đoạn huấn luyện của mô hình MOSS 2 không làm nhiều việc đối sánh giá trị, vì giá trị của con người rất đa dạng. Nhóm chọn cách đối sánh khi suy luận. Có nhiều cách để thực hiện việc đối sánh khi suy luận, có thể sử dụng AI hiến pháp để hướng dẫn nó tuân theo một số nguyên tắc, hoặc sử dụng một số mô hình đã được đối sánh.

Các phương pháp đối sánh đa phương thức hiện nay cũng rất nhiều, nhưng giáo sư Qiu Xipeng nhấn mạnh rằng, hiện nay việc đối sánh đa phương thức chỉ là việc đối sánh nhiệm vụ đa phương thức, việc đối sánh vẫn là việc đối sánh đơn phương thức.

“Một số vấn đề về an toàn có thể thấy từ góc độ đơn phương thức. Một số vấn đề được gọi là đối sánh đa phương thức, từ góc độ đơn phương thức không có gì sai, nhưng khi kết hợp lại có vấn đề. Ví dụ, chụp một bức ảnh tự sướng, chụp một bức ảnh từ tầng cao, đăng một số cảm xúc, mỗi phần xem riêng lẻ không có vấn đề, nhưng khi kết hợp lại có vấn đề. Đây là những điều mọi người cần quan tâm, và thực sự cần giải quyết là việc đối sánh an toàn đa phương thức.”

Nhóm của Qiu Xipeng cũng đã thực hiện nhiều công việc liên quan đến tính giải thích bên trong mô hình. Tính giải thích rất khó, nhóm đã bắt đầu từ các nhiệm vụ nhỏ, ví dụ như việc thực hiện từng bước trong cờ vua, để phân tích các đặc trưng bên trong của Transformer. Gần đây, nhóm cũng đã thử nghiệm trên mô hình ngôn ngữ nhỏ, phát hiện ra nhiều đặc trưng có thể dự đoán mô hình lớn, ví dụ như khi nào mô hình sẽ tạo ra ảo tưởng. Giáo sư Qiu Xipeng cũng đưa ra ví dụ, một số đặc trưng liên quan đến thời gian, khi trả lời câu hỏi đã có thời gian, những đặc trưng này không hoạt động, nhưng khi hỏi về tương lai, những đặc trưng này lại hoạt động.

Ngoài ra, Phòng thí nghiệm Xử lý Ngôn ngữ tự nhiên thuộc Đại học Fudan còn muốn tăng cường khả năng tự điều chỉnh của MOSS. Hiện nay, mô hình lớn không có khả năng tự điều chỉnh, tất cả đều do con người điều chỉnh. “Khi triển khai MOSS trước đây, chúng tôi gặp vấn đề, mong muốn có sự đa dạng trong câu trả lời trong một số tình huống, không mong muốn trong một số tình huống khác, lúc đó chúng tôi đã điều chỉnh một số tham số tốt hơn để đạt được sự cân bằng.” Giáo sư Qiu Xipeng ví dụ.

Trong khi đó, con người thường có khả năng tự điều chỉnh, vì vậy có thể cho phép mô hình lớn như con người, thông qua việc điều chỉnh nhịp tim, huyết áp, sự giải phóng hormone, v.v. để điều chỉnh hành vi của nó. Vì vậy, nhóm đã đề xuất một phương pháp gọi là Hyperparameter Aware Generation (HAG), cho phép mô hình lớn nhận biết sự tồn tại của các tham số siêu và điều chỉnh các tham số này để thích ứng với các tình huống khác nhau.

Như những gì nhóm MOSS đã nói, “sinh sản phiên bản Trung Quốc của ChatGPT vẫn cần sự nỗ lực của toàn bộ cộng đồng AI Trung Quốc, và cũng cần liên tục tương tác với con người để cải thiện khả năng.” Rõ ràng, nhóm đang nỗ lực để đạt được mục tiêu của mình, và chúng ta mong đợi sự ra mắt chính thức của MOSS 2.

Công nghệ mô hình lớn AI đã phát triển nhanh chóng trong thời gian ngắn, việc ra mắt gần đây của GPT-4o đã một lần nữa thu hút sự chú ý của ngành. Vào ngày 21 tháng 6 từ 13:00 đến 18:00, tại sự kiện Azure OpenAI Day, mô hình mới nhất sẽ được trình diễn trực tiếp, mang đến cho bạn trải nghiệm trực quan về sự tiến bộ trong việc xử lý giọng nói, văn bản và hình ảnh. Hãy quét mã để đăng ký và tham dự sự kiện, chúng tôi mong được gặp bạn tại Quảng Châu!

[Tiếp theo là một đoạn tin tức không liên quan đến nội dung chính]

[5 từ khóa]

– MOSS

– Đại học Fudan

– Trí tuệ nhân tạo

– Mô hình ngôn ngữ lớn

– AI

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...