Trong 3 tháng tiêu tốn 10 triệu USD để tạo ra mô hình lớn “mạnh nhất”? Ngựa ô Databricks: Chúng tôi đã đánh bại Grok, Llama còn mở hơn.

DBRX: Mô hình lớn tổng quát mới của Databricks

Ngày 27 tháng 3, công ty khởi nghiệp về trí tuệ nhân tạo Databricks tại Mỹ đã thông báo rằng nhóm nghiên cứu Mosaic của họ đã phát triển mô hình lớn tổng quát (LLM) chung DBRX sẽ được mở mã nguồn. Khách hàng của Databricks có thể sử dụng DBRX thông qua API để huấn luyện lại mô hình tương tự từ đầu hoặc tiếp tục huấn luyện dựa trên các điểm kiểm tra đã chọn.

Theo Databricks, DBRX được lấy cảm hứng từ ChatGPT của OpenAI. Công ty này cho biết họ đã chi khoảng 10 triệu đô la và mất ba tháng để huấn luyện DBRX, đồng thời tuyên bố rằng nó “vượt trội hơn tất cả các mô hình mã nguồn mở hiện tại”. Jonathan Frankle, kiến trúc sư mạng thần kinh chính và người đứng đầu dự án DBRX, đã thông báo với đội ngũ của mình sau khi xác nhận kết quả thử nghiệm: “Chúng ta đã vượt qua tất cả các mô hình hiện tại”.

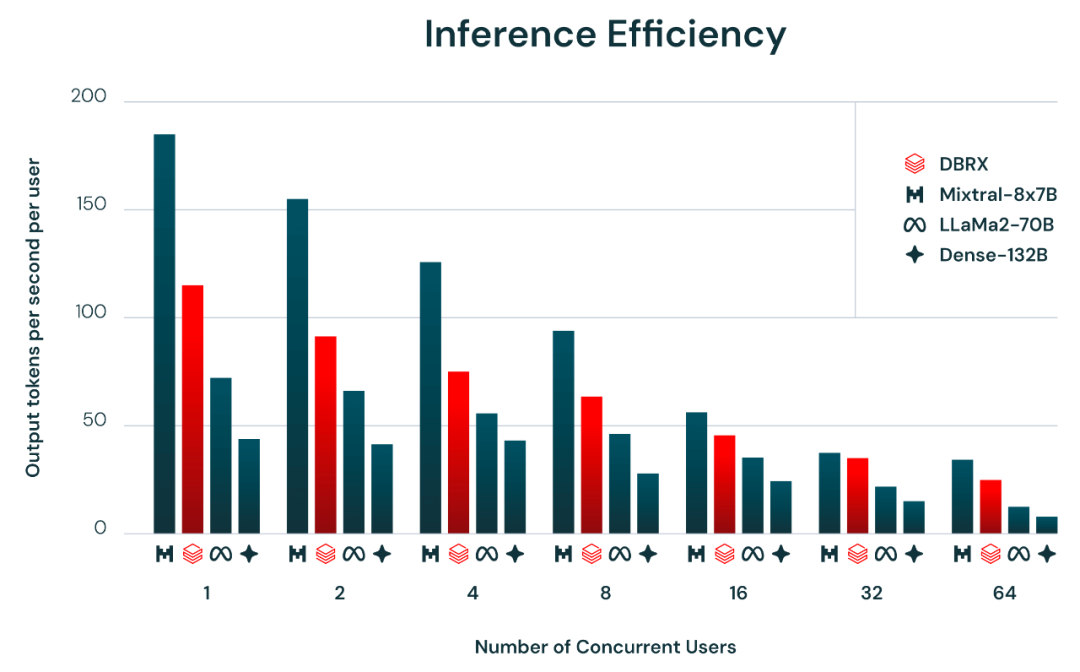

Kết quả kiểm định lượng cho thấy hiệu suất của DBRX đã vượt qua GPT-3.5 và hoàn toàn có thể sánh vai với Gemini 1.0 Pro. Tốc độ suy luận của nó gấp đôi so với LlaMa2-70B; trong khi đó, tổng số tham số và tham số hoạt động của DBRX chỉ bằng khoảng 40% so với Grok-1. Khi được lưu trữ trên Mosaic AI Model Serving, DBRX có thể tạo ra văn bản với tốc độ lên đến 150 token mỗi giây mỗi người dùng. Đồng thời, DBRX cũng là một mô hình mã hóa mạnh mẽ, thậm chí còn vượt qua cả mô hình chuyên biệt như CodeLlaMa-70B.

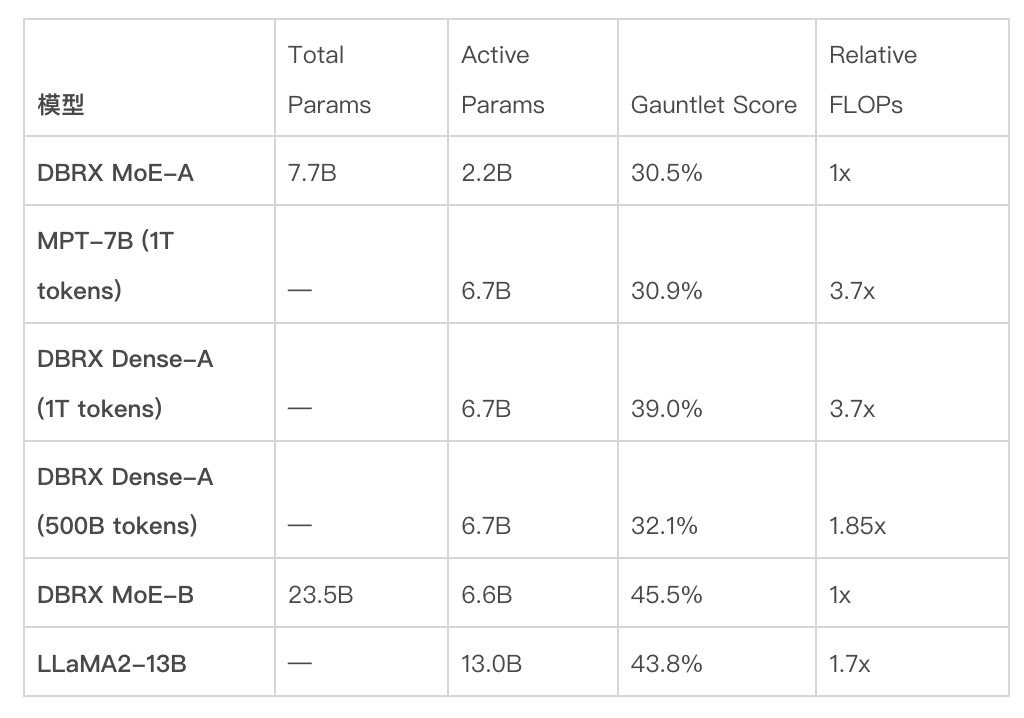

Trong trường hợp chất lượng mô hình cuối cùng giống nhau, hiệu quả FLOP của việc huấn luyện hỗn hợp chuyên gia là gấp đôi so với việc huấn luyện mô hình dày đặc. Từ góc độ tổng thể, công thức toàn bộ (bao gồm dữ liệu huấn luyện trước, kiến trúc mô hình và chiến lược tối ưu hóa) của DBRX hoàn toàn có thể cung cấp chất lượng đầu ra tương đương với thế hệ trước MPT, nhưng chỉ cần phân nửa lượng tính toán.

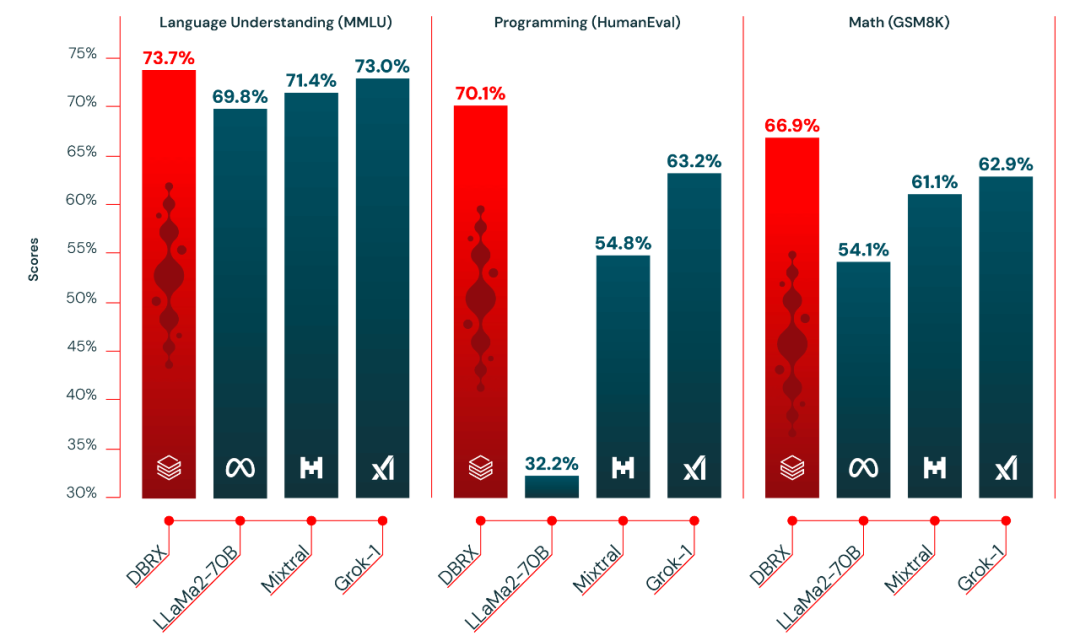

DBRX vượt trội hơn các mô hình mã nguồn mở khác trong việc hiểu ngôn ngữ (MMLU), lập trình (HumanEval) và toán học (GSM8K).

DBRX là một mô hình LLM dựa trên Transformer thuần túy, được huấn luyện bằng cách dự đoán token tiếp theo. Nó sử dụng kiến trúc MoE (hỗn hợp chuyên gia) mịn màng, với tổng cộng 132 tỷ tham số, trong đó 36 tỷ tham số luôn hoạt động với bất kỳ đầu vào nào. DBRX được huấn luyện trước bằng 12 nghìn tỷ token dữ liệu văn bản và mã.

Ngoài ra, DBRX cũng được huấn luyện trên 3072 thẻ NVIDIA H100 được kết nối bằng InfiniBand 3.2 Tbps. Quá trình xây dựng DBRX bao gồm các bước như huấn luyện trước, huấn luyện sau, đánh giá, kiểm tra đỏ và tinh chỉnh, kéo dài trong ba tháng. Databricks cũng tiến hành nghiên cứu và thử nghiệm mở rộng về toán học và tập dữ liệu trong nhiều tháng.

Hiện tại, DBRX đã được tích hợp vào các sản phẩm hỗ trợ AI sinh tạo của Databricks, bao gồm cả ứng dụng SQL, và kết quả ban đầu đã vượt qua GPT-3.5 Turbo và đủ khả năng cạnh tranh với GPT-4 Turbo. DBRX cũng vượt trội hơn GPT-3.5 Turbo và các mô hình mở khác trong các nhiệm vụ RAG.

Hiệu suất suy luận và chất lượng mô hình thường mâu thuẫn với nhau: mô hình lớn hơn thường có chất lượng đầu ra cao hơn, nhưng mô hình nhỏ hơn thường có hiệu suất suy luận tốt hơn. Sử dụng kiến trúc MoE có thể cân nhắc giữa chất lượng mô hình và hiệu suất suy luận, vượt trội hơn hầu hết các mô hình dày đặc. Ví dụ, DBRX có chất lượng cao hơn LlaMa2-70B và do hoạt động tham số chỉ bằng khoảng một nửa, nên DBRX có tốc độ suy luận cao nhất có thể đạt đến gấp đôi (xem hình bên dưới). Mixtral cũng là một minh chứng cho sự cải tiến Pareto của mô hình MoE: kích thước nhỏ hơn, chất lượng thấp hơn, nhưng tốc độ suy luận cao hơn.

Nếu xét về hiệu suất suy luận và chất lượng mô hình, DBRX Instruct đã vượt trội hơn so với các mô hình mở khác trong các bài kiểm tra chuẩn, thậm chí vượt qua tất cả các mô hình điều chỉnh hướng dẫn hoặc điều chỉnh câu lệnh.

Ngoài ra, Databricks cũng đã phát triển các công cụ mà khách hàng tương lai cũng có thể sử dụng, quản lý và quản trị dữ liệu huấn luyện bằng Unity Catalog, khám phá dữ liệu bằng tài sản Lilac AI, và làm sạch và xử lý dữ liệu bằng Apache Spark và Databricks notebooks.

Để xây dựng DBRX, Databricks đã sử dụng phiên bản tối ưu của thư viện huấn luyện mã nguồn mở, bao gồm MegaBlocks, LLM Foundry, Composer và Streaming. Họ cũng sử dụng dịch vụ huấn luyện Mosaic AI để quản lý quy mô lớn của việc huấn luyện và tinh chỉnh mô hình trên hàng nghìn GPU. Kết quả được ghi lại bằng MLflow và thu thập thông tin chất lượng và an toàn từ người dùng thử nghiệm thông qua dịch vụ mô hình và suy luận Mosaic AI.

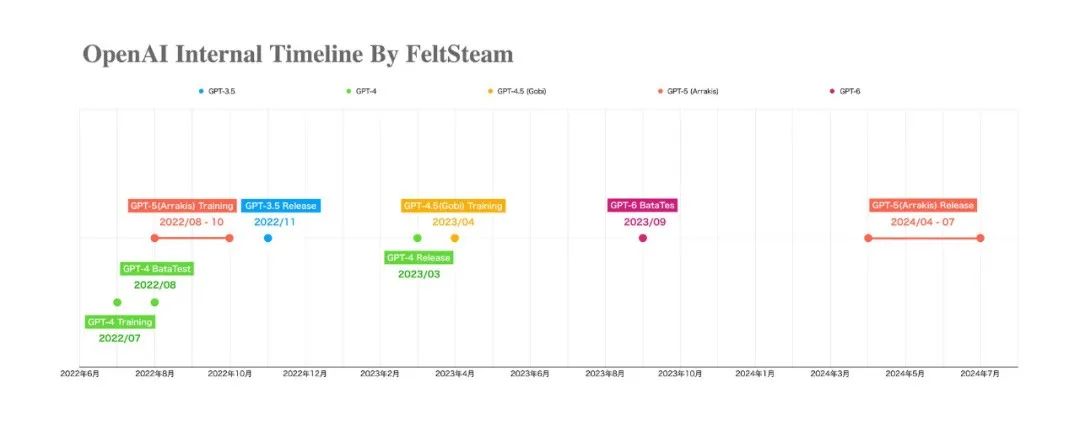

Ngoài ra, thông tin về mô hình AI mới GPT-5 và GPT-6 cũng đang gây xôn xao. Theo một số nguồn tin, GPT-5 dự kiến sẽ được ra mắt vào mùa hè năm nay và đã được một số doanh nghiệp thử nghiệm. GPT-5 được kỳ vọng sẽ mang lại những cải tiến đáng kể về cá nhân hóa, giảm lỗi và khả năng xử lý nhiều loại nội dung hơn, bao gồm cả video.

Cùng với đó, thông tin về GPT-6 cũng đang được lan truyền rộng rãi. Một nguồn tin cho biết, công ty khởi nghiệp AI OpenPipe đã thảo luận với một kỹ sư phụ trách dự án huấn luyện GPT-6 tại Microsoft về vấn đề khó khăn trong việc triển khai kết nối InfiniBand giữa các GPU ở khu vực khác nhau. Điều này cho thấy quy mô và độ phức tạp của việc huấn luyện mô hình AI lớn như GPT-6.

Thách thức và cơ hội trong việc áp dụng mô hình lớn đang diễn ra. Hiện nay, phần lớn mô hình ngôn ngữ đã hoàn thành ba vòng cập nhật, và chỉ còn vài vé để tham gia vào cuộc đua mô hình lớn. Hơn 200 mô hình lớn đã ra mắt trong năm 2023, và xu hướng phát triển của chúng như thế nào?

Tóm lại, DBRX không chỉ là một bước tiến quan trọng trong lĩnh vực trí tuệ nhân tạo, mà còn là một minh chứng cho sức mạnh của việc phát triển mô hình lớn. Sự cạnh tranh không ngừng nghỉ giữa các mô hình mở và mô hình đóng đang thúc đẩy sự tiến bộ không ngừng trong lĩnh vực này.

Từ khóa:

- DBRX

- AI

- Mô hình lớn

- Databricks

- GPT-5

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...