Ba dòng lệnh, mô hình lớn cho phép Excel trả lời trực tiếp câu hỏi.

Giải Quyết Truy Vấn Bảng Dữ Liệu với Mô Hình Ngôn Ngữ Lớn (LLMs)

Một trong những lĩnh vực đang thu hút sự chú ý lớn trong ngành xử lý và phân tích dữ liệu là việc sử dụng các mô hình ngôn ngữ lớn (LLMs) để giải quyết truy vấn bảng dữ liệu. Bài viết này sẽ khám phá cách chúng ta có thể tận dụng LLMs để thực hiện các truy vấn bảng dữ liệu một cách hiệu quả.

Nền tảng Công nghệ

Bài viết này tập trung vào hai công nghệ chính: LlamaIndex và LocalAI. LlamaIndex được thiết kế để áp dụng các nguyên tắc từ các bài báo nghiên cứu hàng đầu như “Rethinking Tabular Data Understanding with Large Language Models” và “Chain-of-Table: Evolving Tables in the Reasoning Chain for Table Understanding”. Điều này giúp chuyển đổi lý thuyết thành thực tế, cho phép người dùng dễ dàng tương tác với LLMs. LocalAI cung cấp môi trường chạy LLMs tại chỗ, cho phép người dùng khởi động và tương tác với LLMs một cách nhanh chóng và tiện lợi.

Tìm Hiểu về LlamaIndex

LlamaIndex là một khung đa năng giúp xây dựng ứng dụng mô hình ngôn ngữ lớn. Nó đơn giản hóa quá trình lấy dữ liệu từ nhiều nguồn và định dạng khác nhau, bao gồm API, PDF, tài liệu và SQL. Khung này đặc biệt mạnh mẽ trong việc sử dụng chỉ mục và cấu trúc dữ liệu bảng để đảm bảo tính tương thích mượt mà với LLMs. Một tính năng quan trọng của nó là giao diện tìm kiếm và truy vấn tiên tiến, cho phép người dùng đưa ra các gợi ý và nhận phản hồi chứa thông tin ngữ cảnh.

Llama Packs: Gói Tùy Chỉnh

Llama Packs bổ trợ cho LlamaIndex bằng cách cung cấp các mô-đun đã được đóng gói sẵn để đẩy nhanh quá trình phát triển ứng dụng LLM. Các mô-đun này được thiết kế cho nhiều trường hợp sử dụng khác nhau, từ việc tạo ứng dụng Streamlit đến việc thực hiện truy vấn nâng cao và trích xuất dữ liệu cấu trúc từ hồ sơ. Một tính năng quan trọng của Llama Packs là khả năng tùy chỉnh, cho phép người dùng không chỉ sử dụng các mô-đun có sẵn mà còn tùy chỉnh theo nhu cầu cụ thể của họ.

LocalAI: Môi Trường Tại Chỗ

LocalAI nhằm mục đích chạy dịch vụ mô hình ngôn ngữ lớn mã nguồn mở tại chỗ và cung cấp API tương thích hoàn toàn với OpenAI. Điều này cung cấp một giải pháp độc đáo cho những người muốn giữ tính linh hoạt của OpenAI nhưng vẫn muốn chạy các mô hình tại chỗ. LocalAI hỗ trợ nhiều mô hình và kiến trúc khác nhau, cho phép chạy hiệu quả ngay cả trên máy không có GPU.

Thực Hiện Dự Án

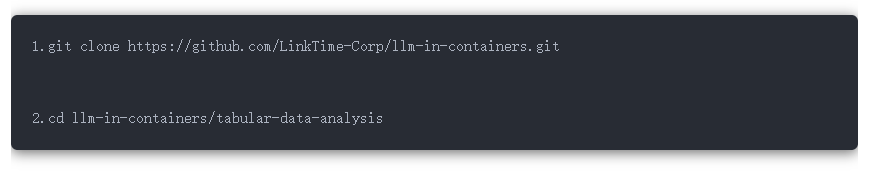

Để bắt đầu dự án, bạn cần sao chép kho lưu trữ vào máy tính của mình:

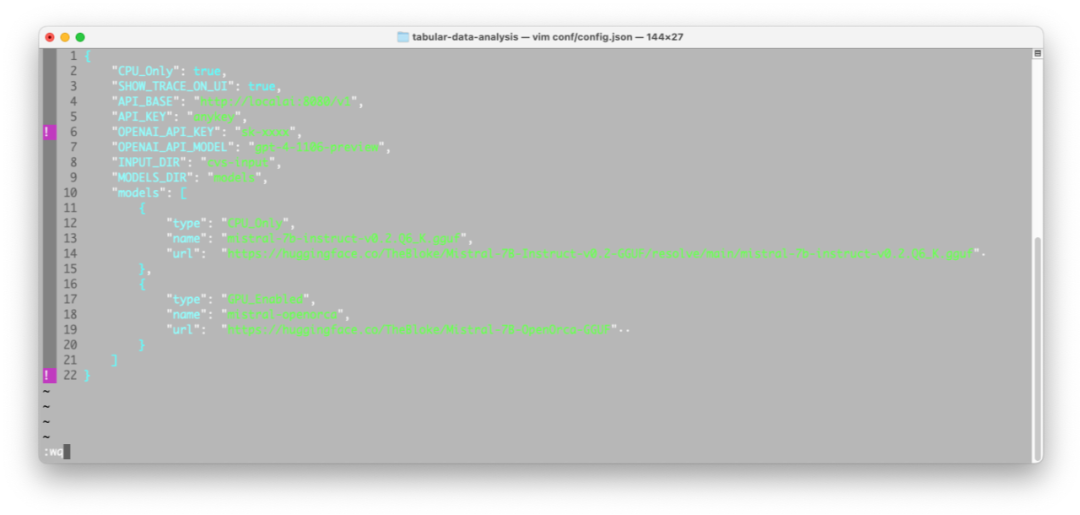

Nếu bạn muốn sử dụng mô hình của OpenAI để suy luận, hãy đặt khóa API của OpenAI vào file conf/config.json ở mục “OPENAI_API_KEY”:

Nếu bạn chưa đăng ký OpenAI, hãy thay đổi giá trị “OPENAI_API_MODEL” thành “gpt-3.5-turbo”.

Khởi Động Dự Án

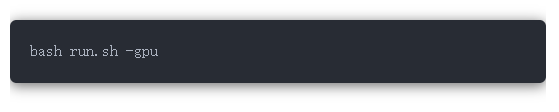

Bạn cần khởi động Docker Desktop để bắt đầu:

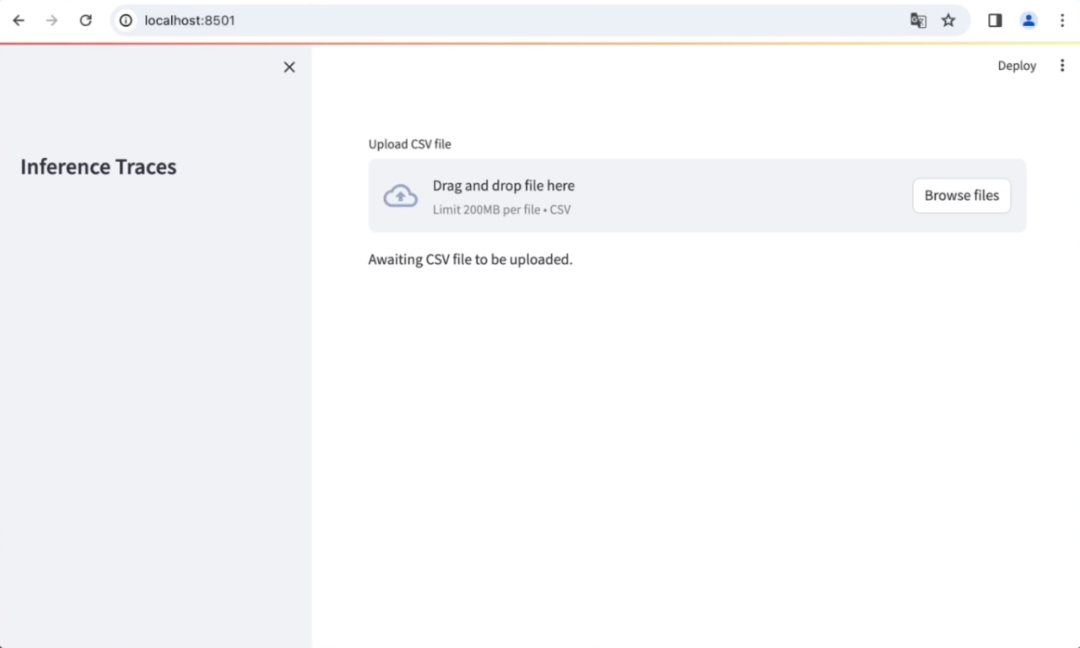

Sau đó, truy cập giao diện người dùng tại địa chỉ http://localhost:8501/:

Để tải dữ liệu mẫu, hãy truy cập liên kết sau (https://github.com/ppasupat/WikiTableQuestions/releases/download/v1.0.2/WikiTableQuestions-1.0.2-compact.zip), giải nén file và sử dụng file CSV từ thư mục “WikiTableQuestions/csv/200-csv/11.csv”.

Thử Nghiệm với Các Công Cụ

Bạn có thể chọn giữa “MixSelfConsistency” và “ChainOfTable” để truy vấn dữ liệu bảng. Mỗi công cụ đều có ưu điểm riêng:

- MixSelfConsistency: Sử dụng lặp lại và hợp nhất kết quả từ “text reasoning” và “symbolic reasoning” để cải thiện độ chính xác.

- ChainOfTable: Xây dựng chuỗi thao tác để chuyển đổi bảng dữ liệu gốc thành định dạng phù hợp hơn với câu hỏi.

Ví dụ, câu hỏi “Ai đã giành giải Oscar Nam diễn viên chính xuất sắc nhất năm 1972?” có thể được trả lời bằng cách sử dụng cả hai công cụ này.

Kết Luận

Công nghệ mới này không chỉ giúp chúng ta tiếp cận dữ liệu bảng một cách hiệu quả hơn, mà còn mở ra nhiều cơ hội mới trong việc tương tác với dữ liệu cấu trúc. Thông qua sự kết hợp của LlamaIndex và LocalAI, chúng ta có thể tạo ra hệ thống mạnh mẽ và linh hoạt để giải quyết các truy vấn bảng dữ liệu.

Từ Khóa

- Mô hình Ngôn ngữ Lớn (LLMs)

- LlamaIndex

- LocalAI

- Bảng dữ liệu

- Truy vấn bảng

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...