Meta công khai cơ sở hạ tầng đào tạo Llama-3: Sử dụng 49.000 H100.

Meta Ra Mắt Hai Bộ Phân Tích GPU Mới Cho Model Llama-3

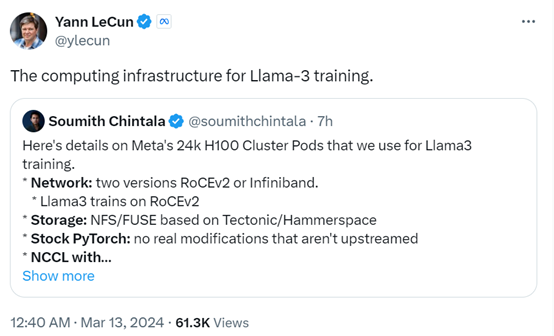

Vào ngày 13 tháng 3, tập đoàn công nghệ và mạng xã hội lớn nhất thế giới, Meta, đã công bố hai bộ phân tích GPU mới sử dụng cho việc huấn luyện model Llama-3. Mỗi bộ phân tích này bao gồm 24.576 GPU H100, với tổng số GPU là 49.152.

Llama-3 được xây dựng dựa trên mạng RoCEv2 và sử dụng hệ thống lưu trữ mạng NFS/FUSE dựa trên nền tảng Tectonic/Hammerspace. Model này tiếp tục sử dụng thư viện học máy PyTorch.

Theo tiến trình huấn luyện hiện tại, dự kiến Llama-3 sẽ được ra mắt vào cuối tháng 4 hoặc đầu tháng 5. Model này có thể sẽ là một mô hình đa phương tiện và tiếp tục được mở mã nguồn.

Một thông tin quan trọng khác từ Meta, họ đang hướng tới việc sở hữu 600.000 GPU H100 vào cuối năm 2024, nhằm tăng cường khả năng nghiên cứu và phát triển AI.

Trước đó, vào ngày 24 tháng 1 năm 2022, Meta đã công bố chi tiết về siêu máy tính AI RSC, với 16.000 GPU Nvidia A100, đã đóng vai trò quan trọng trong việc phát triển các model như Llama và Llama 2, cũng như các ứng dụng liên quan đến thị giác máy tính, xử lý ngôn ngữ tự nhiên và nhận diện giọng nói, cũng như tạo ảnh.

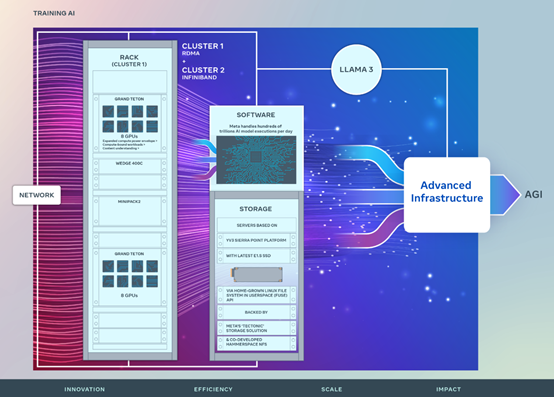

Các bộ phân tích GPU mới này được xây dựng dựa trên kinh nghiệm thành công của RSC, cho phép hỗ trợ việc huấn luyện model phức tạp hơn với nhiều tham số hơn. Để đảm bảo trung tâm dữ liệu hoạt động ổn định, Meta sử dụng giải pháp mạng với kết cấu Ethernet Remote Direct Memory Access (RoCE) và NVIDIA Quantum2 InfiniBand, giúp kết nối các điểm 400 Gbps.

Đồng thời, Meta cũng đã thành công trong việc sử dụng các cluster RoCE và InfiniBand cho các tác vụ AI quy mô lớn, không gặp phải bất kỳ bottleneck nào về mạng.

Ngoài ra, hai bộ phân tích GPU mới này đều sử dụng Grand Teton, một nền tảng phần cứng GPU do chính Meta thiết kế, được công bố lần đầu vào ngày 18 tháng 10 năm 2022.

Grand Teton được xây dựng dựa trên nhiều thế hệ hệ thống AI, tích hợp nguồn điện, kiểm soát, tính toán và giao diện cấu trúc vào một hộp, giúp cải thiện hiệu suất tổng thể, tín hiệu hoàn chỉnh và hiệu suất làm mát.

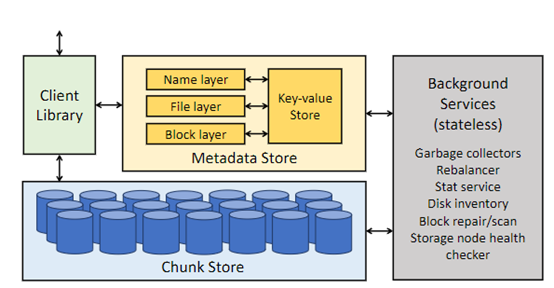

Với sự phát triển của các model lớn, nhu cầu lưu trữ dữ liệu cũng tăng lên nhanh chóng. Meta đã triển khai hệ thống lưu trữ mới của mình thông qua API hệ điều hành Linux người dùng, được tối ưu hóa bởi giải pháp lưu trữ phân tán Tectonic của Meta.

Giải pháp này cho phép hàng nghìn GPU đồng bộ lưu và tải các checkpoint, cung cấp lưu trữ ngoài byte cấp độ linh hoạt và tốc độ cao.

Meta cũng đã hợp tác với Hammerspace để phát triển và triển khai hệ thống file mạng song song (NFS), đáp ứng yêu cầu lưu trữ cho các cluster AI siêu cấp.

Hammerspace còn cho phép các kỹ sư tương tác với các tác vụ bằng cách sử dụng hàng nghìn GPU, vì tất cả các nút trong môi trường đều có thể truy cập ngay lập tức vào các thay đổi mã.

Kết hợp giải pháp lưu trữ phân tán Tectonic của Meta và Hammerspace, quá trình cải tiến chức năng có thể diễn ra nhanh chóng mà không làm ảnh hưởng đến quy mô.

Keywords:

- Meta

- Llama-3

- GPU

- Tectonic

- Hammerspace

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...