Mistral AI: Khám phá thông lượng, độ trễ và chi phí trong suy diễn LLM.

Hiệu suất và Chi phí trong Triển khai Mô hình Ngôn ngữ Lớn

Bài viết này sẽ tập trung vào việc triển khai mô hình ngôn ngữ lớn như Mistral và LLaMA, với trọng tâm đặc biệt là về hiệu suất và chi phí. Mục tiêu chính là tối ưu hóa quá trình giải mã, tăng cường hiệu suất và giảm thiểu chi phí.

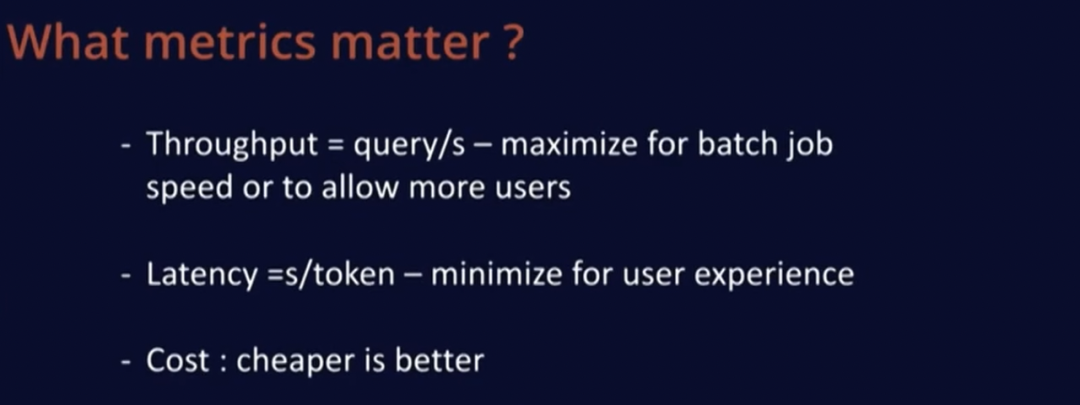

Chỉ số quan trọng

Có ba chỉ số chính cần xem xét khi triển khai mô hình ngôn ngữ lớn:

- Số lượng truy vấn mỗi giây (Queries per second): Điều này giúp tối ưu hóa việc xử lý nhiều yêu cầu cùng một lúc.

- Thời gian mỗi từ (Seconds per token): Đây là thời gian cần thiết để xuất ra từ tiếp theo, quyết định tốc độ của ứng dụng.

- Chi phí: Đây là yếu tố quan trọng không kém, vì chúng ta muốn giảm thiểu chi phí mà vẫn đảm bảo hiệu suất tốt.

Đối tượng và Yếu tố ảnh hưởng

Hiệu suất của mô hình phụ thuộc vào nhiều yếu tố, bao gồm phần cứng và phần mềm. Phần cứng như GPU có thể thực hiện một số lượng nhất định các phép tính nổi (FLOPs), trong khi phần mềm cũng cần được tối ưu hóa để đạt hiệu suất cao nhất.

Các kỹ thuật cải thiện hiệu suất

Có một số kỹ thuật đã được áp dụng và một số khác chưa được áp dụng nhưng rất hữu ích:

- Phân nhóm truy vấn chú ý (Grouped Query Attention): Giảm bộ nhớ KV bằng cách sử dụng ít hơn các khóa và giá trị cho mỗi truy vấn.

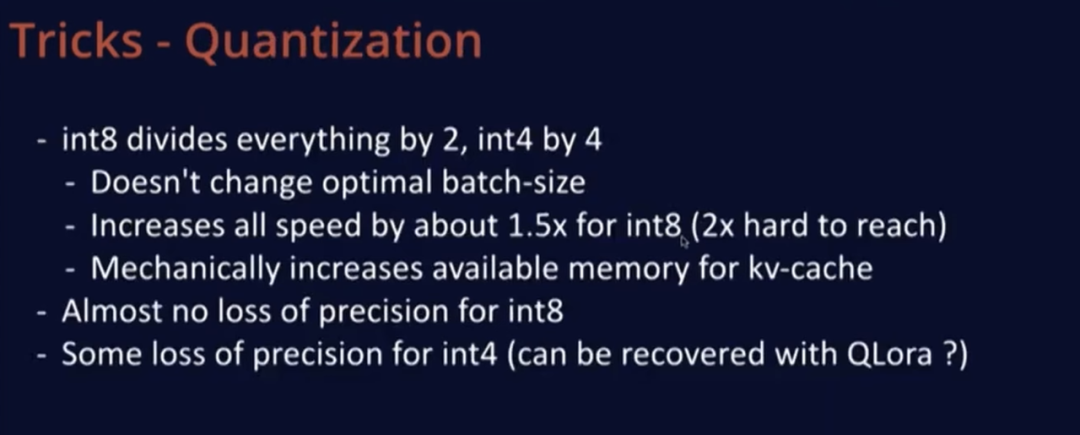

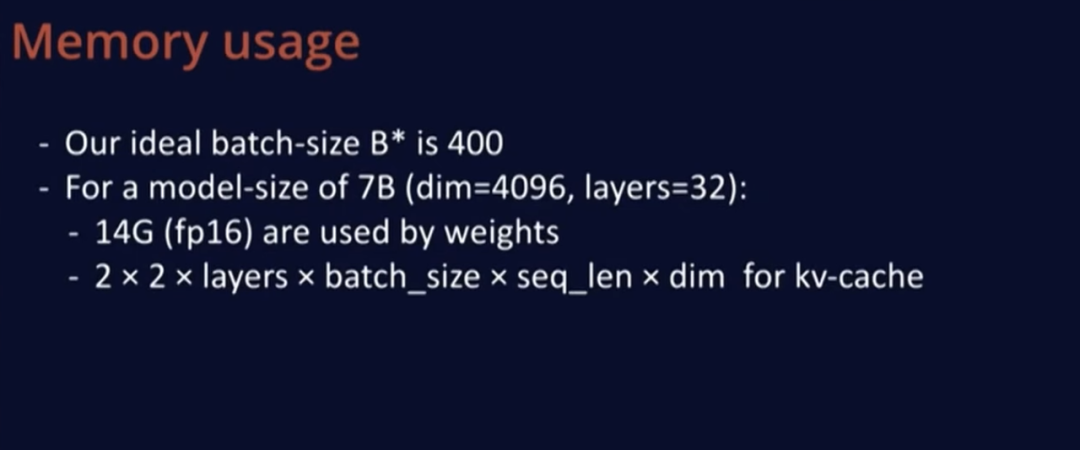

- Quantization: Giảm kích thước mô hình bằng cách chuyển đổi sang định dạng int8 hoặc int4, giúp tăng tốc độ và giảm chi phí.

- Attention paging: Phân bổ bộ nhớ theo từng khối, giúp tối ưu hóa việc sử dụng bộ nhớ.

- Sliding window attention: Sử dụng bộ đệm cố định, giúp tối ưu hóa việc sử dụng bộ nhớ và tăng hiệu suất.

- Batching liên tục: Kết hợp giai đoạn tiền xử lý và giải mã để tối ưu hóa việc sử dụng tài nguyên.

Phân tích hiệu suất

Thông qua việc phân tích hiệu suất, chúng ta có thể thấy rằng việc lựa chọn phần cứng phù hợp và tối ưu hóa phần mềm đều đóng vai trò quan trọng. Việc tăng tốc mã nguồn thông qua việc sử dụng thư viện như XFormers và TensorRT cũng rất quan trọng.

Kết luận

Triển khai mô hình ngôn ngữ lớn đòi hỏi sự cân nhắc giữa hiệu suất và chi phí. Thông qua việc áp dụng các kỹ thuật tối ưu hóa và lựa chọn phần cứng phù hợp, chúng ta có thể đạt được hiệu suất cao nhất với chi phí thấp nhất.

Từ khóa

- Triển khai mô hình

- Hiệu suất

- Chi phí

- Optimization

- Quantization

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...