MiniMax ra mắt mô hình ngôn ngữ lớn MoE đầu tiên trong nước, đối trọng với OpenAI GPT-4.

MoE trong Mô hình Lớn của MiniMax: Sự tiến bộ và tiềm năng

Mô hình Lớn (Big Models) đang trở thành một phần quan trọng trong lĩnh vực trí tuệ nhân tạo, đặc biệt là trong việc xử lý ngôn ngữ tự nhiên. MiniMax, một công ty hàng đầu trong lĩnh vực này, đã giới thiệu mô hình abab6, một phiên bản cải tiến của mô hình abab5.5 với cấu trúc MoE (Mixture of Experts – Phối hợp Chuyên gia). Vậy, MoE là gì và tại sao nó lại quan trọng đối với mô hình abab6?

Giới thiệu về MoE

Mô hình MoE là một phương pháp tích hợp, trong đó toàn bộ vấn đề được chia thành nhiều tác vụ con, và mỗi tác vụ con sẽ được huấn luyện bởi một nhóm chuyên gia riêng biệt. Mô hình MoE có khả năng xử lý dữ liệu từ nhiều học viên (chuyên gia) khác nhau.

Nghe đồn rằng, GPT-4 cũng sử dụng cấu trúc tương tự.

Mô hình abab6 của MiniMax

Vào tháng 4 năm 2023, MiniMax đã ra mắt nền tảng mở cửa. Trong hơn nửa năm qua, MiniMax đã phục vụ gần nghìn khách hàng, bao gồm các công ty hàng đầu như Kingsoft Office, Xiaohongshu, Tencent, Xiaomi và Yuedu. Nền tảng mở cửa của MiniMax trung bình xử lý hàng trăm tỷ token mỗi ngày.

Trong bài viết trên tài khoản Weibo chính thức, MiniMax cho biết: “Trong nửa năm qua, khách hàng đã cung cấp cho chúng tôi rất nhiều phản hồi và lời khuyên quý giá. Ví dụ, họ đánh giá cao khả năng của chúng tôi trong việc viết lách, trò chuyện và trả lời câu hỏi, đạt đến mức độ của GPT-3.5.”

Tuy nhiên, so với mô hình tiên tiến nhất là GPT-4, abab5.5 vẫn còn khoảng cách đáng kể. Điều này thể hiện rõ trong việc xử lý các tác vụ phức tạp hơn, đòi hỏi độ chính xác cao hơn. Mặc dù đây không chỉ là vấn đề của abab5.5, mà hầu hết các mô hình lớn khác ngoài GPT-4 đều gặp phải.

Nhóm kỹ thuật của MiniMax

Để giải quyết vấn đề này và nâng cao hiệu suất của mô hình trong các tác vụ phức tạp, nhóm kỹ thuật của MiniMax đã bắt đầu phát triển mô hình MoE – abab6, là phiên bản thứ hai của mô hình MoE (phiên bản đầu tiên đã được áp dụng trong sản phẩm dành cho người dùng cuối).

Mặc dù MiniMax chưa tiết lộ thông số cụ thể của abab6, nhưng họ cho biết abab6 lớn hơn gấp nhiều lần so với phiên bản trước. Một mô hình lớn hơn có thể học được các quy luật chi tiết hơn từ dữ liệu huấn luyện và thực hiện các tác vụ phức tạp hơn.

Tuy nhiên, việc tăng quy mô mô hình cũng mang lại những thách thức mới: giảm tốc độ suy luận và tăng thời gian huấn luyện. Trong nhiều ứng dụng, tốc độ huấn luyện và hiệu suất của mô hình đều quan trọng như nhau. Để đảm bảo tốc độ tính toán của abab6, nhóm kỹ thuật của MiniMax đã sử dụng cấu trúc MoE, trong đó các thông số của mô hình được phân thành nhiều nhóm “chuyên gia”, và mỗi lần suy luận chỉ có một phần nhỏ chuyên gia tham gia.

Kết quả đánh giá

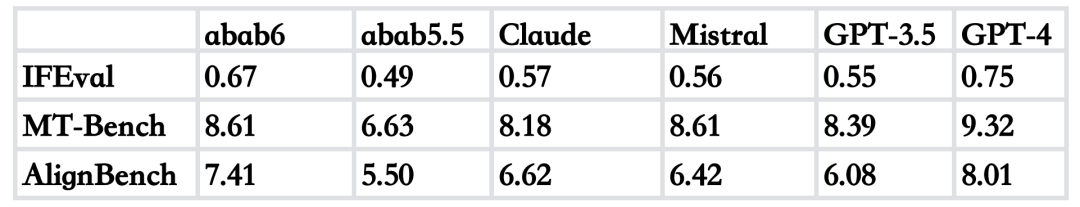

Để so sánh hiệu suất của các mô hình trong các tác vụ phức tạp, MiniMax đã tiến hành đánh giá tự động cho abab6, abab5.5, GPT-3.5, GPT-4, Claude 2.1 và Mistral-Medium. Đối với các tác vụ đơn giản, abab5.5 đã làm tốt, vì vậy MiniMax đã chọn ba phương pháp đánh giá bao gồm các vấn đề phức tạp hơn:

- IFEval: Đánh giá khả năng tuân thủ lệnh của mô hình. Các câu hỏi có điều kiện được đặt ra để xem mô hình có đáp ứng đúng yêu cầu hay không.

- MT-Bench: Đánh giá khả năng tổng hợp tiếng Anh của mô hình bằng cách đặt nhiều loại câu hỏi khác nhau.

- AlignBench: Đánh giá khả năng tổng hợp tiếng Trung của mô hình.

Kết quả cho thấy, abab6 vượt trội hơn so với abab5.5 trong cả ba bài kiểm tra. Trong việc tuân thủ lệnh, khả năng tổng hợp tiếng Trung và tiếng Anh, abab6 đều vượt trội hơn so với GPT-3.5. So với Claude 2.1, abab6 cũng vượt trội hơn trong việc tuân thủ lệnh, khả năng tổng hợp tiếng Trung và tiếng Anh. So với Mistral-Medium, abab6 vượt trội hơn trong việc tuân thủ lệnh và khả năng tổng hợp tiếng Trung, trong khi khả năng tổng hợp tiếng Anh tương đương.

Kết luận

Mô hình abab6 của MiniMax, dựa trên cấu trúc MoE, đã chứng minh sự vượt trội trong việc xử lý các tác vụ phức tạp và đòi hỏi độ chính xác cao. Nếu bạn muốn trải nghiệm mô hình này, hãy truy cập nền tảng mở cửa của MiniMax.

Chúng tôi hoan nghênh mọi phản hồi từ cộng đồng.

Từ khóa

- Mô hình lớn (Big Models)

- MoE (Phối hợp Chuyên gia)

- MiniMax

- GPT-4

- abab6

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...