Ultraman bị trói buộc bởi “cái chong chóng”? OpenAI phát hành hướng dẫn an toàn dài 27 trang, hội đồng có quyền phủ quyết việc phát hành mô hình AI mới.

OpenAI, công ty đứng sau ChatGPT, đã đưa ra kế hoạch nhằm kiểm soát những rủi ro có thể xảy ra từ các công nghệ AI đang được phát triển. CEO của OpenAI, Sam Altman, đã tham gia diễn đàn toàn cầu tại Atlanta, nơi ông tái khẳng định cam kết của mình trong việc đảm bảo rằng lợi ích của trí tuệ nhân tạo không trở thành mối đe dọa đối với cộng đồng toàn cầu.

Mới đây, OpenAI đã công bố một khung chính sách dài 27 trang nhằm quản lý và giảm thiểu các rủi ro liên quan đến các mô hình AI tiên tiến. Theo đó, OpenAI sẽ thiết lập một nhóm chuyên trách để giám sát và giảm thiểu các rủi ro tiềm ẩn từ các mô hình AI. Nhóm này sẽ chịu trách nhiệm đánh giá và theo dõi các rủi ro liên quan, từ việc sử dụng AI cho các cuộc tấn công mạng quy mô lớn cho đến việc hỗ trợ sản xuất vũ khí sinh học, hóa học hoặc hạt nhân.

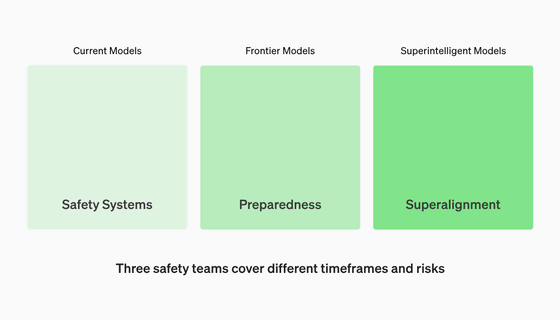

Một phần quan trọng của kế hoạch này là việc OpenAI sẽ thành lập một nhóm tên là “Superalignment”, cùng với hai nhóm khác, để đảm bảo an ninh của các mô hình AI mà công ty đang phát triển. Nhóm này sẽ do giáo sư Aleksander Madry, người hiện đang nghỉ phép từ MIT, dẫn đầu. Ông sẽ giám sát một đội ngũ nghiên cứu, chịu trách nhiệm đánh giá và theo dõi các rủi ro tiềm ẩn.

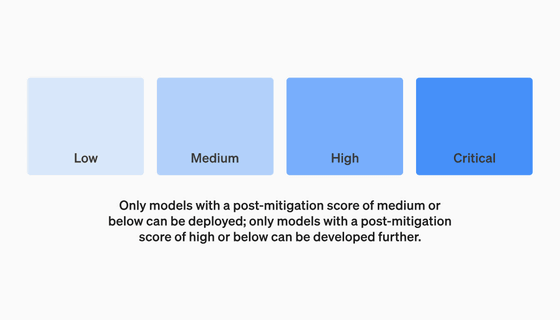

Ngoài ra, OpenAI cũng đã thành lập một nhóm tư vấn an ninh, chịu trách nhiệm giám sát quyết định về an ninh và cơ sở hạ tầng vận hành. Nhóm này sẽ cung cấp báo cáo thường xuyên về các mô hình AI và gửi chúng cho ban quản lý và hội đồng quản trị. Ban quản lý có quyền quyết định xem liệu có nên phát hành mô hình AI hay không dựa trên báo cáo này, nhưng hội đồng quản trị vẫn giữ quyền phủ quyết.

OpenAI nhấn mạnh rằng, hiện tại, khung chính sách này đang trong giai đoạn thử nghiệm beta và sẽ tiếp tục được cập nhật dựa trên phản hồi. Tuy nhiên, sự tập trung vào việc quản lý rủi ro và đảm bảo an ninh của AI đã gây ra nhiều tranh cãi, đặc biệt là sau cuộc chiến quyền lực nội bộ gần đây tại công ty.

Trong bối cảnh các nhà khoa học và nhà nghiên cứu hàng đầu kêu gọi coi việc giảm thiểu rủi ro diệt vong do AI là ưu tiên hàng đầu, OpenAI đã xác định rõ vị thế của mình như một người đi đầu trong việc giải quyết các vấn đề an ninh AI. Tuy nhiên, sự thiếu đa dạng trong thành phần hội đồng quản trị tạm thời và sự phụ thuộc vào việc tự điều chỉnh của công ty đã khiến nhiều người hoài nghi về hiệu quả của các biện pháp này.

Cuối cùng, mặc dù OpenAI đã đưa ra các biện pháp mạnh mẽ để quản lý rủi ro AI, nhưng cần có sự tham gia tích cực hơn từ phía các cơ quan quản lý và công chúng để đảm bảo rằng AI được phát triển một cách an toàn và có trách nhiệm.

#AI #AnToàn #TríTuệNhânTạo #OpenAI #RủiRo

© Thông báo bản quyền

Bản quyền bài viết thuộc về tác giả, vui lòng không sao chép khi chưa được phép.

Những bài viết liên quan:

Không có đánh giá...